надеюсь я успею все это асилить до того как ссылки протухнут))))

Просмотр статьи

Просмотр резюме

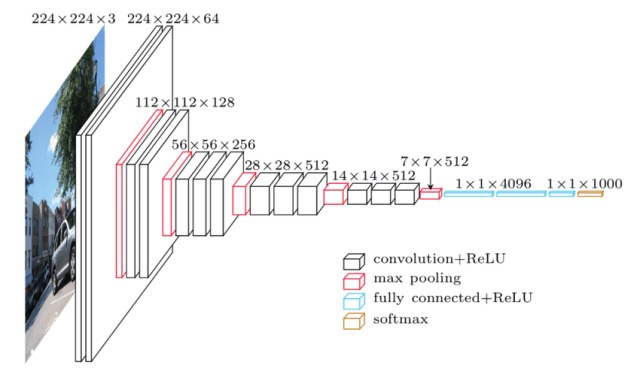

Глубокое обучение: ImageNet Classification with Deep Convolutional Neural Networks (Университет Торонто)

Generative Adversarial Networks (GAN, 2014, Монреальский университет)

Very Deep Convolutional Networks for Large-Scale Image Recognition (VGGNet, 2014)

VGGNet Deep Residual Learning for Image Recognition

VGGNet Deep Residual Learning for Image Recognition (ResNet, 2015)

Going Deeper with Convolutions (GoogleNet, 2015)

Unsupervised Representation Learning with Deep Convolutional Generative Adversarial Networks (2016, Монреальский университет)

Dynamic Routing Between Capsules (2017, Google Brain)

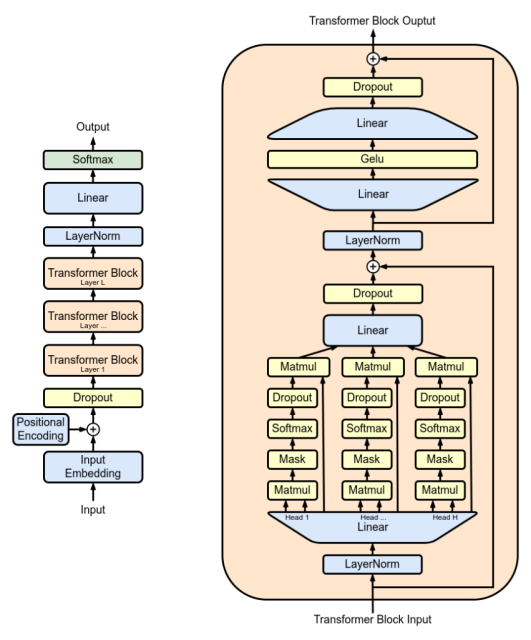

Transformer (2017). Легендарная статья

Attention is all you need с описанием архитектуры Transformer. С неё началось развитие

больших языковых моделей, в том числе чат-бота

ChatGPT (ноябрь 2022), который стал вирусным мегахитом

неожиданно даже для своих создателей (на самом деле в нём нет никаких технических нововведений, кроме удобного интерфейса взаимодействия с пользователями через браузер)

Обработка естественного языка: Efficient Estimation of Word Representations in Vector Space (Word2Vec, Mikolov et al., 2013)

GLUE: A Multi-Task Benchmark and Analysis Platform for Natural Language Understanding (Wang et al., 2018)

ELMo (Peters et al., 2018, Allen Institute for Artificial Intelligence)

Improving Language Understanding by Generative Pre-Training (GPT-1, Radford et al., 2018)

GPT-1 (Generative Pre-trained Transformer 1) BERT

GPT-1 (Generative Pre-trained Transformer 1) BERT (Devlin et al., 2018, Google)

RoBERTa: A Robustly Optimized BERT Pretraining Approach (2019, Facebook AI)

Transformer-XL: Attentive Language Models Beyond a Fixed-Length Context (2019, Google AI Language)

XLNet: Generalized Autoregressive Pretraining for Language Understanding (2019, Google AI Language)

GPT-2 (2019, OpenAI)

T5: Exploring the Limits of Transfer Learning with a Unified Text-to-Text Transformer (2020, Google Research)

GPT-3 (2020, OpenAI)

An Image is Worth 16x16 Words: Transformers for Image Recognition at Scale (2020, Vision Transformer, ViT)

Language Models are Few-Shot Learners (2021, OpenAI)

Обучение с подкреплением: Q-Learning (Watkins & Dayan, 1992)

SARSA (R. S. Sutton & Barto, 1998)

DQN (Mnih et al., 2013)

A3C (Mnih et al., 2016)

PPO (Schulman et al., 2017)

Эксперты предлагают добавить в этот список

WaveNet (генеративная модель для звука),

Seq2Seq, несколько статей по оптимизаторам (например,

Adam), диффузионным моделям и некоторым последним вариантам архитектуры Transformer.

В принципе получился очень лаконичный, качественный и вполне исчерпывающий список научных работ для хорошего погружения в тему. Как говорил Илья Суцкевер, вы получите представление о 90% того, что нужно знать (хотя оставшиеся 10% могут быть сложнее, чем первые 90%).

источник: https://habr.com/ru/company/ruvds/blog/721150/